Stambia

The solution to all your data integrations needs

Stambia

The solution to all your data integrations needs

El componente de Stambia para Apache Spark

Apache Spark es un marco de trabajo (framework) de código abierto (open source) para Big Data, bien conocido por su alta velocidad de procesamiento de datos y facilidad de uso. Proporciona reusabilidad, tolerancia a fallas, procesamiento de tiempo real y muchas otros atributos.

El componente de Stambia para Apache Spark está concebido para proporcionar a los usuarios la habilidad de automatizar, industrializar y gestionar sus proyectos Spark, además de ser ágil en sus implementaciones.

Apache Spark: ¿Por qué usted necesita una solución E-LT?

Automatice los esfuerzos para desarrollar y gestionar manualmente las aplicaciones Spark

Cuando se trabaja en proyectos que manejan Big Data, frecuentemente se prefiere el uso de Apache Spark para el procesamiento de una enorme cantidad de datos. Ha sido utilizado por Ingenieros de datos y científicos de datos (Data Scientists) para realizar diferentes tipos de operaciones y análisis de datos. Se requiere gran cantidad de elaboración de código al construir aplicaciones complejas, lo cual pueden hacerse difíciles de gestionar a largo plazo. Automatizar el esfuerzo puede ser muy beneficioso para la productividad de la organización.

Por otro lado, una aplicación Spark escrita en Java será difícil de interpretar por parte de otro miembro del equipo con conocimiento de Python. Una solución que pueda desplegar una capa consistente sobre este código, de manera que el diseño sea agnóstico en relación al código elaborado en el fondo, puede cambiar la dinámica del proyecto y proporcionar agilidad.

Muchas organizaciones están moviendo sus datos hacia la nube, algunas son híbridas y ahora ha comenzado la adopción del multinube (multi-cloud), en esos casos el uso de herramientas que reducen las complejidades de migrar su aplicación Spark a un entorno diferente mediante automatización permite ahorrar una enorme cantidad de tiempo.

Una solución complementaria para trabajar con el Motor de Análisis Unificado

Apache Spark es conocido como un Motor de Análisis Unificado (Unified Analytics Engine) el cual incluye módulos prefabricados para streaming de datos, SQL, Aprendizaje de máquina, etc. Todas estas características deben ser soportadas por herramientas de integración de datos.

Esto requiere una solución que no solo tenga la habilidad de trabajar con todo tipo de tecnologías pero que también proporcione una plataforma consistente y unificada, para ser capaz de gestionar tanto proyectos tradicionales como proyectos de Big Data con las mismas capacidades.

Por ejemplo, proyectos como el simple intercambio de datos entre aplicaciones, procesamiento de registros enormes, procesamiento en tiempo real, etc. pueden fácilmente ser diseñados usando diferentes herramientas, lo cual añade complejidades al sistema de información.

Utilizar una solución que pueda trabajar de la misma manera cuando se manejan sistemas de archivos, bases de datos, servidores, brókers de mensajería, clusters, etc. es de gran importancia.

Obtenga beneficios de un procesamiento de datos más rápido y un rendimiento mejorado

Apache Spark es conocido por ser 100 veces más rápido que Hadoop, debido a su optimizador de consultas, motor físico, reducción del número de lecturas y escrituras de disco y procesamiento en memoria (in-memory).

El concepto de conjunto de datos distribuidos resilientes (Resillient Distributed Dataset o RDD) permite almacenar datos en memoria y mantenerlos en el disco sólo cuando se requiera. Spark proporciona un API de alto nivel en Java, Scala, Python y R, y posee módulos de aprendizaje de máquina.

Al utilizar una solución de integración de datos es importante dejar que Spark realice el levantamiento pesado. Frecuentemente, herramientas ETL con un motor propietario son demasiado pesadas para ser utilizadas con Spark.

En primer lugar, un motor ETL no tiene utilidad si ya posees Spark, en segundo lugar, el tiempo dedicado a administrar y configurar se hace tedioso.

Habilidad de adaptarse a las mejoras constantes en Apache Spark

Al ser Apache Spark un proyecto de código abierto, está en un proceso constante de actualización, por parte de la comunidad, para incorporar nuevas características y mejoras.

Los desarrolladores necesitan mantenerse al día con lo último y lo mejor para mantenerse actualizando sus aplicaciones, de manera de poder utilizar características nuevas.

En algunos casos, esto puede impactar los procesos existentes, y tomaría un esfuerzo significativo para actualizarlos.

En estos casos, una solución que pueda ayudar a reducir el tiempo y el esfuerzo requerido para actualizar, puede simplificar en gran medida las cosas para los ingenieros de datos, con el fin de permitirles enfocarse en su trabajo cotidiano de proyectos.

Reduzca el costo de propiedad

Al ser un marco de trabajo (framework) de código abierto, Spark también es rentable en términos del tipo de almacenamiento requerido en comparación con Hadoop.

Debido a su facilidad de uso y a la disponibilidad de diferentes API en varios lenguajes, los desarrolladores con estas habilidades pueden aprender a usarlo fácilmente y comenzar a construir aplicaciones.

Al utilizar una solución de integración de datos para su proyecto Spark, es importante considerar el costo a largo plazo de la propiedad de la solución.

Características del componente de Stambia para Apache Spark

El componente de Stambia para Apache Spark proporciona una manera de diseñar las aplicaciones Spark fácil de usar y basada en arrastrar y soltar elementos (drag n drop).

Algunos de los beneficios clave que resultan de usar este componente son:

- Automatización – Al usar el mapeador universal de datos (Universal Data mapper), las aplicaciones Spark se generan durante la ejecución.

- Industrialización – Varios tipos de plantillas Spark, que sólo es necesario escribir una vez, puede ser distribuidas a varios equipos.

- Fácil manejo – Hacer cambios usando una GUI en lugar de trabajar en un complejo código escrito.

Automatice con Stambia para generar aplicaciones Spark mediante Drag n Drop

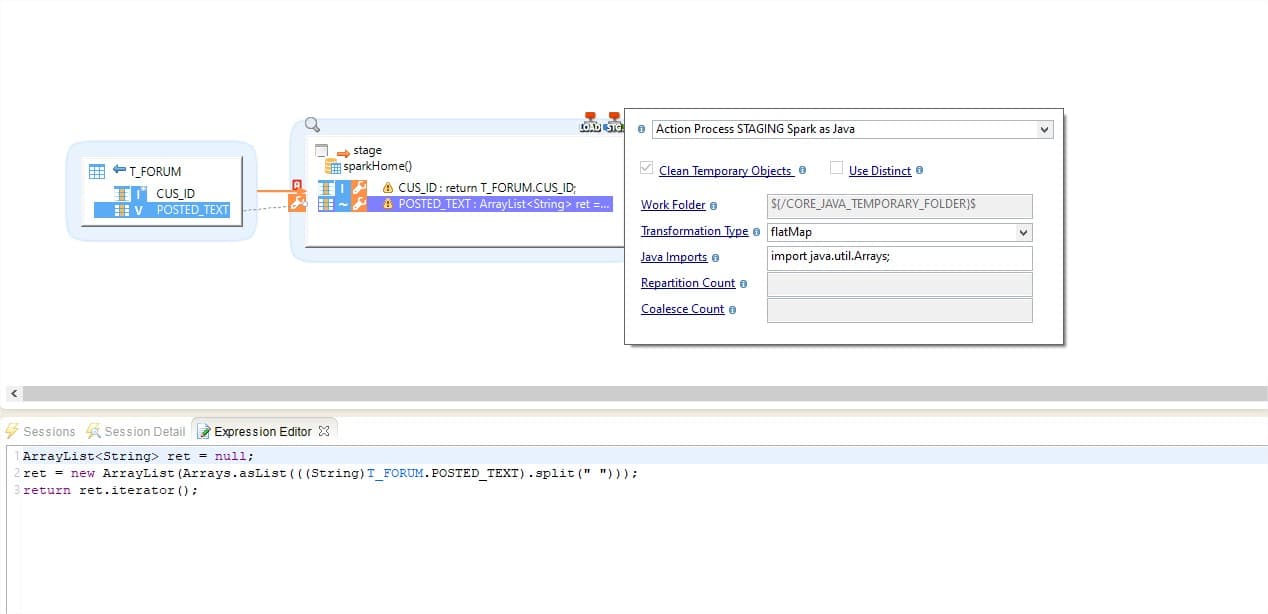

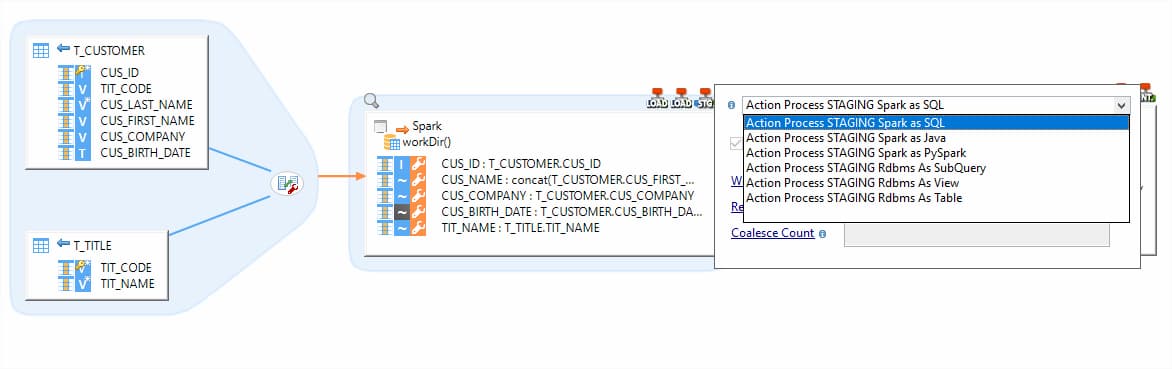

Stambia proporciona un mapeador universal de datos (Universal Data mapper o UDM), el cual se basa en un enfoque descendente (Top Down). Al utilizar la GUI, usted gestiona la extracción de datos desde al fuente hacia el cluster Spark y puede así escribir las transformaciones Spark.

A través del UDM, usted proporciona las instrucciones mediante transformaciones rápidas, las cuales son utilizadas durante la ejecución por las plantillas de Stambia para construir la aplicación Spark.

Las plantillas pueden ser de Spark Java, Spark SQL, Pyspark, etc, por lo que son agnósticas en relación a las habilidades y la experticia de los usuarios. Equipos con diferentes conjuntos de habilidades pueden usarlas de manera consistente y comenzar a construir los diseños y seleccionar sus plantillas preferidas para crear código Java, SQL, Python o R.

Una solución unificada para cualquier tipo de proyecto

Stambia es una solución de integración de datos unificada que funciona bien con Apache Spark y puede trabajar con diferentes tipos de tecnologías.

En cualquier sistema de información existen diferentes tipos de requerimientos de datos provenientes de varias aplicaciones y sistemas fuente, los cuales no requieren necesariamente el mismo tratamiento.

Con Stambia, diferentes equipos que trabajen en, por ejemplo, un proyecto de almacén de datos (data warehouse) que involucre una base de datos de tipo Teradata, así como un proyecto de streaming en tiempo real con un bróker de mensajería como Kafka, o un proyecto de lago de datos (data lake) en la nube como AWS, GCP o Azure, en el que se debe lidiar con bases de datos Data Storage, SQL y No SQL, etc. puede ser manejado dentro de la misma herramienta de diseño (designer).

Con el Mapeador Universal de Datos, todos pueden diseñar los flujos de datos de una manera consistente, sin importar el tipo de proyecto o de tecnología involucrada, lo cual le da incluso una mayor confianza en satisfacer las necesidades actuales de futuras de datos.

Stambia: Un enfoque ELT para dejar que Spark haga el trabajo pesado

Stambia es una solución ELT que trabaja bajo el concepto de "Delegación de transformaciones".

Esto significa que el diseño que usted crea se traduce en código nativo para la tecnología subyacente.

En el caso de Spark, todo el arrastrar y soltar (drag n drop) que usted realice, desde la fuente hacia el destino, todas las transformaciones que usted elabore, así como las funciones que usted desarrolle, son traducidas en forma de aplicación Spark.

Stambia, con su huella ligera, producirá el código Spark y dejará que los usuarios lo gestionen y monitoricen a través de una GUI de fácil uso.

Solución fácilmente personalizable y adaptable a su disposición

Stambia, debido a su noción de plantillas, puede ser fácilmente personalizable sin cambiar los diseños actuales. Las plantillas son objetos globales que albergan el código de generación del programa Spark.

Estas pueden ser personalizadas rápidamente, mejoras y actualizadas para cualquier versión de Spark. Plantillas dedicadas específicas para una versión también pueden ser mantenidos dentro de su proyecto.

Como resultado de esto, cada vez que hay una nueva versión de Spark, los diseños/mapeos existentes no se ven impactados. Un simple reemplazo de la última plantilla en los proyectos es suficiente para actualizarlos.

Por otro lado, desarrolladores proactivos pueden modificar estas plantillas para incorporar funcionalidades sin ninguna limitación, de manera de industrializar sus personalizaciones e innovaciones compartiéndolas con diferentes equipos.

Ser dueño de una solución con un claro costo de propiedad

Stambia provee un modelo de precios simple y fácil de leer. No se basa en el número de fuentes, volúmenes de datos a ser manejados o el número de oleoductos de integración.

Con un método sencillo para determinar precios, el equipo Stambia trabaja de cerca en sus proyectos para ayudarle a comprender y definir las fases de su proyecto, así como para tener control de los costos a cada paso.

Especificaciones y prerrequisitos técnicos

| Especificaciones | Descripción |

|---|---|

|

Protocolo |

JDBC, HTTP |

|

Estructurado y semiestructurado |

XML, JSON |

| Lenguajes soportados |

La aplicación Spark puede ser producida para:

|

| Conectividad |

Usted puede extraer datos desde:

Para más información, consulte la documentación técnica |

|

Tecnologías Hadoop |

Los siguientes conectores Hadoop dedicados están disponibles: 1. Almacén de datos (Datawarehouse) |

| Rendimiento de carga de datos | Los rendimientos se incrementan cuando se cargan o extraen datos a través de ciertas opciones en los conectores que permiten configurar de manera específica cómo los datos son procesados, como seleccionar Spark jdbc load, o cargadores de datos específicos desde la base de datos. |

| Versión del Runtime de Stambia | Stambia DI Runtime S17.4.6 o superior |

¿Desea saber más?

Consulte nuestros diferentes recursos

¿No ha encontrado lo que deseaba en esta página?

Consulte otro de nuestros recursos

Stambia anuncia su fusión con Semarchy the Intelligent Data Hub™

Stambia Data Integration se convierte en Semarchy xDM Data Integration